自然言語処理をする際、データソースとして Wikipedia を使用することがあります。 Wikipedia を使う際、ページによっては内容が薄いので、ページを選択することがあります。 そのための方法として、Wikipedia 内のページランクを計算して、重要ページを抽出する方法が提案されています。

本記事では、Wikipedia 内のページランクを計算して、重要なページを抽出する方法を紹介します。 ツールとしては Project Nayuki で公開されているツールを使います。 このツールは Stanford の SQuAD のデータセットを作成する際にも使われています。

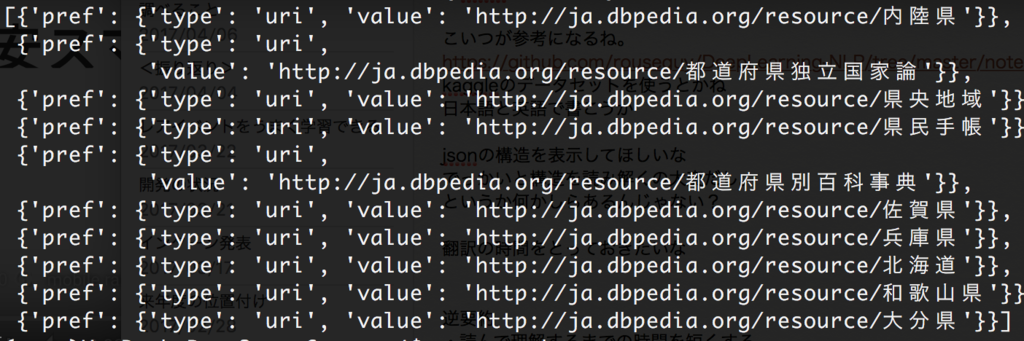

では、日本語版 Wikipedia を用いて、ページランクを計算してみます。

続きを読む