NAACL 2019より以下の論文を紹介。

この論文では、英語の固有表現認識のデータセットを使って学習させたモデルを転移学習させることで、日本語の固有表現認識の性能向上を行う手法を提案している。モチベーションの一つとして、今までのクロスリンガルな転移学習は英語とドイツ語、英語とスペイン語のような似た言語に対して焦点を当てていたが、英語と日本語のような似ていない言語には焦点をあまり当ててこなかったという背景がある。実験の結果、提案したモデルによる転移学習が効果的であることを示した。

日本語と英語の転移学習が英語とドイツ語などの転移学習と比べて難しいのは、同じアルファベットを使っていない点にある。ご存知のように、英語やドイツ語ではアルファベットとしてラテン文字が使われている。そのため、転移学習する際には、ベースとなるアルファベットの重みを活用しやすい。それに対して、日本語ではアルファベットとして漢字やひらがななどが使われている。これらのアルファベットは基本的に英語のテキストでは出てこないので、良い重みを学習できていないという問題がある。

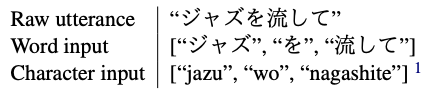

この問題を解決するために、この論文では日本語のローマ字化(romanizing)を行っている。ローマ字化を行うことで、たとえば「欧州」を「oushuu」に変換できる。こうすると、英語と日本語で共通のアルファベットを利用できるので良い結果を得られるのではないかということだ。ただし、日本語には同音異義語が多いという問題がある。たとえば、「欧州」と「押収」はどちらも「oushuu」に変換されてしまい単語の曖昧性の問題が出てきてしまう。そこで、ローマ字化した単語だけでなく、元の単語も利用している。以下にモデルへの入力を示す。

モデルは、Lampleの提案したモデルとほぼ同じモデルを使っている。以下に図を示す。このモデルでは、文字ベースの入力が文字BiLSTMに与えられ、その出力が単語分散表現と連結される。その連結した結果は単語BiLSTMに与えられる。単語BiLSTMからの出力は全結合層に与えられ、その後はソフトマックス層からタグの確率を出力する。

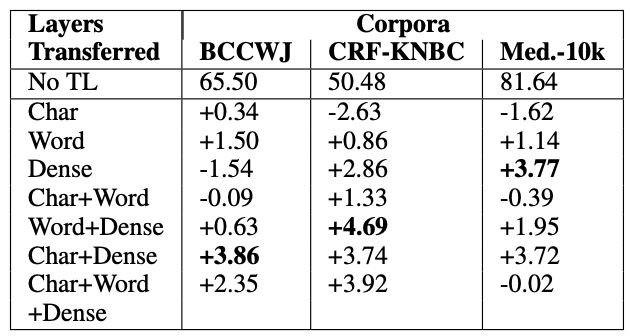

実験設定としては4つほどあるのだが、ここでは2つを示す。まずは、モデルのどの層の組み合わせを転移するのが効果的なのかという検証をしている。ここで転移する層の候補としては、文字BiLSTM、単語BiLSTM、全結合層の3つとなっている。ちょうど上のモデルアーキテクチャの図の中で色で囲まれた部分が候補となっている。3つのデータセットに対して、転移する層の組み合わせを変えて実験したところ以下の結果を得られた。結果としては、文字+全結合層を転移するのが最も安定的に良い結果を得られることがわかった。

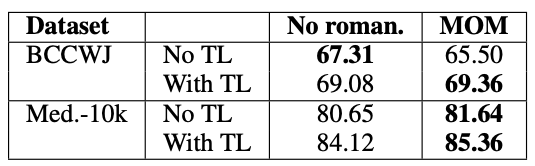

次に2つのデータセットに対してローマ字化の効果を検証している。結果を以下に示す。結果を見ると、転移学習する際に日本語のローマ字化を行うことで性能が向上していることがわかる。

前に紹介した多言語BERTの転移性能についての論文では、多言語BERTを使った場合の転移性能は語彙の重なりに依存しないという結果を得られていたので、そういう意味では、この論文で使っているローマ字化のような手法は、今後使われるかと問われると、そうではないと思う。テクニックとしては面白いが、本質的には文法の違いを捉えられるモデルが必要になるのではないか。