グローバルなコンテキストを使って固有表現認識の性能を改善する

ACL 2019より以下の論文を紹介。

この論文では、文レベルのグローバルな文脈表現を利用した系列ラベリングのモデルを提案している。従来、品詞タグ付や固有表現認識、チャンキングといった系列ラベリングタスクにはBiLSTMが使われてきた。しかし、BiLSTMではグローバルな文脈表現を十分に捉えられていないという課題がある。それを解決するためにグローバルな文脈を捉えられるモデルを提案し検証。結果として、固有表現認識とチャンキングでSOTAを記録した。

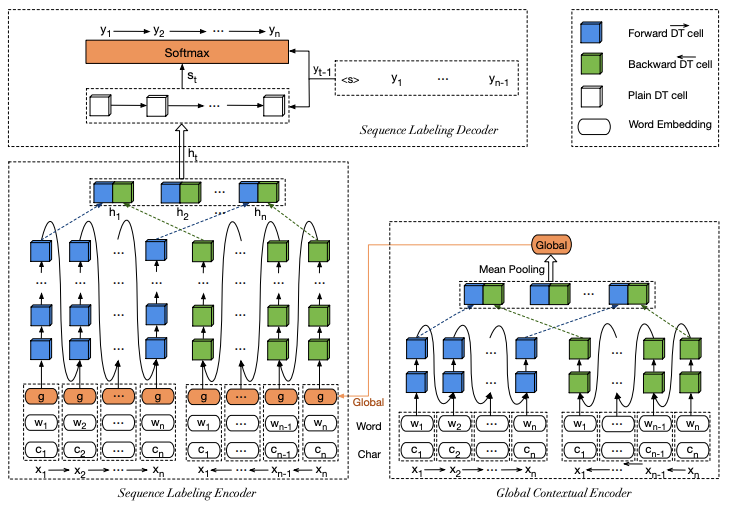

提案するモデルは、グローバルコンテキストエンコーダ、系列ラベリングエンコーダ、デコーダの3つのモジュールから構成される。以下に図を示した。全体としては、まず入力のトークン表現を単語、文字、グローバルの3つを連結して作成する。ここでグローバルな表現はグローバルコンテキストエンコーダの隠れ状態の平均プーリングで作る。これらの連結したトークン表現を系列ラベリングエンコーダに入れて変換した後、デコーダを使ってラベルを予測する。

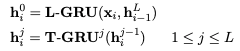

3つのモジュールで使われているキーとなる技術がDeep Transition RNN(DT)だ。DTは通常のRNNより次の状態までの遷移が深いのが特徴となっている。DTはL-GRUとT-GRUから構成され、式としては以下で表される。意味的には、前のL番目のT-GRUからの出力をL-GRUに与え、L-GRUからの出力はT-GRUに与える式になっている。モデルのアーキテクチャ図を見るとその様子がわかりやすい。図ではトークン表現を直接与えているのがL-GRU、それ以降がT-GRUとなる。

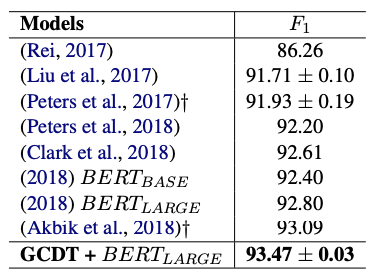

実験は固有表現認識とチャンキングという2つの系列ラベリングタスクに対して行っている。データセットは、固有表現認識はCoNLL 2003、チャンキングはCoNLL 2000という標準的に使われているデータセットを用いている。固有表現認識の結果は以下の通り。結果を見るとF1で93.47となっている。SOTAが93.5くらいだったはずなので、ほとんどSOTAに等しい結果となっており、非常に強力なモデルであることが示された。

BiLSTMをDTに変えたこと、またグローバルなコンテキストを使ったことで性能を改善している。DTの実装はそんなに難しくなさそうなので、今後は研究的にはBiLSTMに変わってこのような深い遷移を行うモデルがスタンダードになっていくかもしれないので、関連研究を抑えておく必要がありそう。