ACL 2019より以下の論文を紹介。こういう系列ラベリングのやり方もあるか、と思った一本。

この論文では、入力文中のトークンをラベルの付いたデータベース中のトークンに対して近傍検索を行うことで系列ラベリングを行う手法を提案している。一般的な系列ラベリングを解く手法と異なり、検索によって系列ラベリングを行うのが面白いところ。実験は品詞タグ付けと固有表現認識に対して行い、まずまずの性能と高いzero-shot learning性能を示した。

この論文で提案する手法では、系列ラベリングを検索によって行う。入力系列を、予測を

とする。そのとき、データベースから

個の文と対応する出力系列のペア

を検索する。その情報を基に、

番目の入力

のラベル

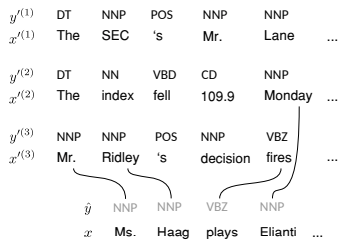

を予測する。以下に品詞タグ付けのイメージを挙げた。たとえば、入力文中の「Ms」のラベルは、データベース中の「Mr」と「Ms」が近いことがわかれば決定できることを示している。

検索によってラベルを決めるので、必要なのは入力文中の番目のトークン

とデータベース中の

番目の文の

番目のトークン

の類似度を計算することになる。式にすると以下のように計算することになる。ここで、

と

はそれぞれ、文脈を考慮したトークンの表現方法となっている。以下ではこれらの表現はBERTから得たものとしている。

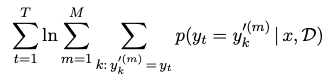

BERTから得たトークンをそのまま使ってもいいのだが、この論文ではそれらのトークンの表現を以下の目的関数を最大化することでFine-tuningしている。式の意味としては、入力文中のトークンとデータベース中のトークンでラベルが一致するものがあればその確率が大きくなるようにトークンの表現をチューニングするというような意味になっている。

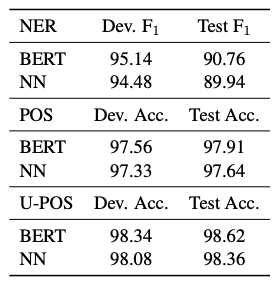

実験は固有表現認識と品詞タグ付けについて行っている。品詞タグ付けは通常のPenn Treebankの品詞タグとUniversal品詞タグを使っている。その結果は以下の通り。著者たちはBERTをFine-tuneした場合に匹敵する性能を得られたと主張している。ただ、この表のBERTの値はBERTの論文から持ってきたものではないことに注意する必要がある。

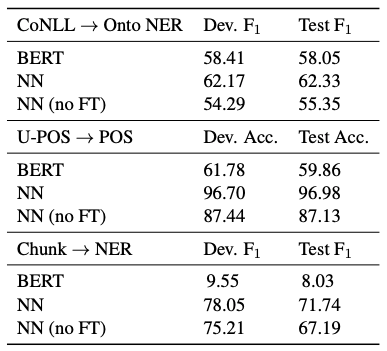

次に、Zero-shot Learningの性能を示している。設定としては、3つあり、CoNLLで学習させてOntoNoteで予測を行うパターン、Universal品詞タグを学習させて通常の品詞タグを予測するパターン、チャンキングを学習させて固有表現認識を学習させるパターンとなっている。その結果は以下の通り。BERTをFine-tuneするより遥かに良い結果を得られていることが確認できる。

勉強不足なもので、こういった方法で系列ラベリングをできることに感心した。普通に固有表現認識や品詞タグ付けをする分にはそれほど性能は高くないが、タスク間のZero-shot learningの性能はなかなか優秀に見える。この手法が言語間の転移も可能になるのかは気になるところではある。